主要职责

中国科学院贯彻落实党中央关于科技创新的方针政策和决策部署,在履行职责过程中坚持党中央对科技工作的集中统一领导。主要职责是:

一、开展使命导向的自然科学领域基础研究,承担国家重大基础研究、应用基础研究、前沿交叉共性技术研究和引领性颠覆性技术研究任务,打造原始创新策源地。 更多+

院况简介

中国科学院是国家科学技术界最高学术机构、国家科学技术思想库,自然科学基础研究与高技术综合研究的国家战略科技力量。

1949年,伴随着新中国的诞生,中国科学院成立。建院70余年来,中国科学院时刻牢记使命,与科学共进,与祖国同行,以国家富强、人民幸福为己任,人才辈出,硕果累累,为我国科技进步、经济社会发展和国家安全作出了不可替代的重要贡献。 更多+

院领导集体

科技奖励

科技期刊

科技专项

科研进展/ 更多

工作动态/ 更多

工作动态/ 更多

中国科学院学部

中国科学院院部

语音播报

近期,中国科学院软件研究所研究团队为提升大语言模型时间序列预测性能,提出了向量注入式上下文学习框架。该框架能够稳定提升时间序列预测性能,并可以降低计算开销。

大语言模型进行时间序列预测时面临一项主要挑战——预训练文本与时间序列数据在分布与结构上存在差异。传统方法采用全量微调来减少这种差异,但其训练成本高、显存占用大,限制了实际应用。

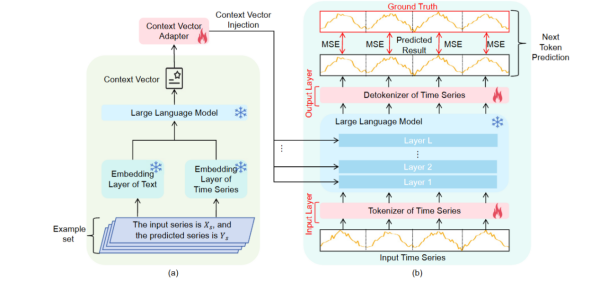

研究团队提出引入上下文学习的方法LVICL。该方法通过在输入提示中引入任务示例,使模型无需更新参数即可实现“类似微调”的效果。为提升上下文学习对示例选择与顺序敏感的不稳定问题,该方法提取示例的向量表示,并以置换不变的方法进行聚合,从而消除顺序敏感性;采用轻量适配器对聚合后的上下文向量进行精练,抑制其中可能干扰预测的分量,增强对示例选择的鲁棒性;将优化后的向量注入到大语言模型各层的残差流中,以可控方式引导模型进行预测。

研究团队在多个时间序列预测基准数据集上对LVICL进行系统评估。实验表明,LVICL在保持大语言模型完全冻结、训练开销降低的前提下,能够稳定复现并进一步放大上下文学习带来的收益。与轻量微调方法相比,LVICL在多种数据集与实验设置下均表现出更强的预测能力,并在效率与性能的平衡上展现出更好的实用性。

相关论文被互联网领域顶级国际学术会议The Web Conference 2026(WWW-26)录用。

LVICL总体框架

扫一扫在手机打开当前页

© 1996 - 中国科学院 版权所有 京ICP备05002857号-1  京公网安备110402500047号 网站标识码bm48000002

京公网安备110402500047号 网站标识码bm48000002

地址:北京市西城区三里河路52号 邮编:100864

电话: 86 10 68597114(总机) 86 10 68597289(总值班室)